#38 5 Arten von Deepfakes und ihre Betrugsmuster

Zahlreiche Beispiele, warum wir unseren Sinnen in der digitalen Welt nicht mehr trauen können

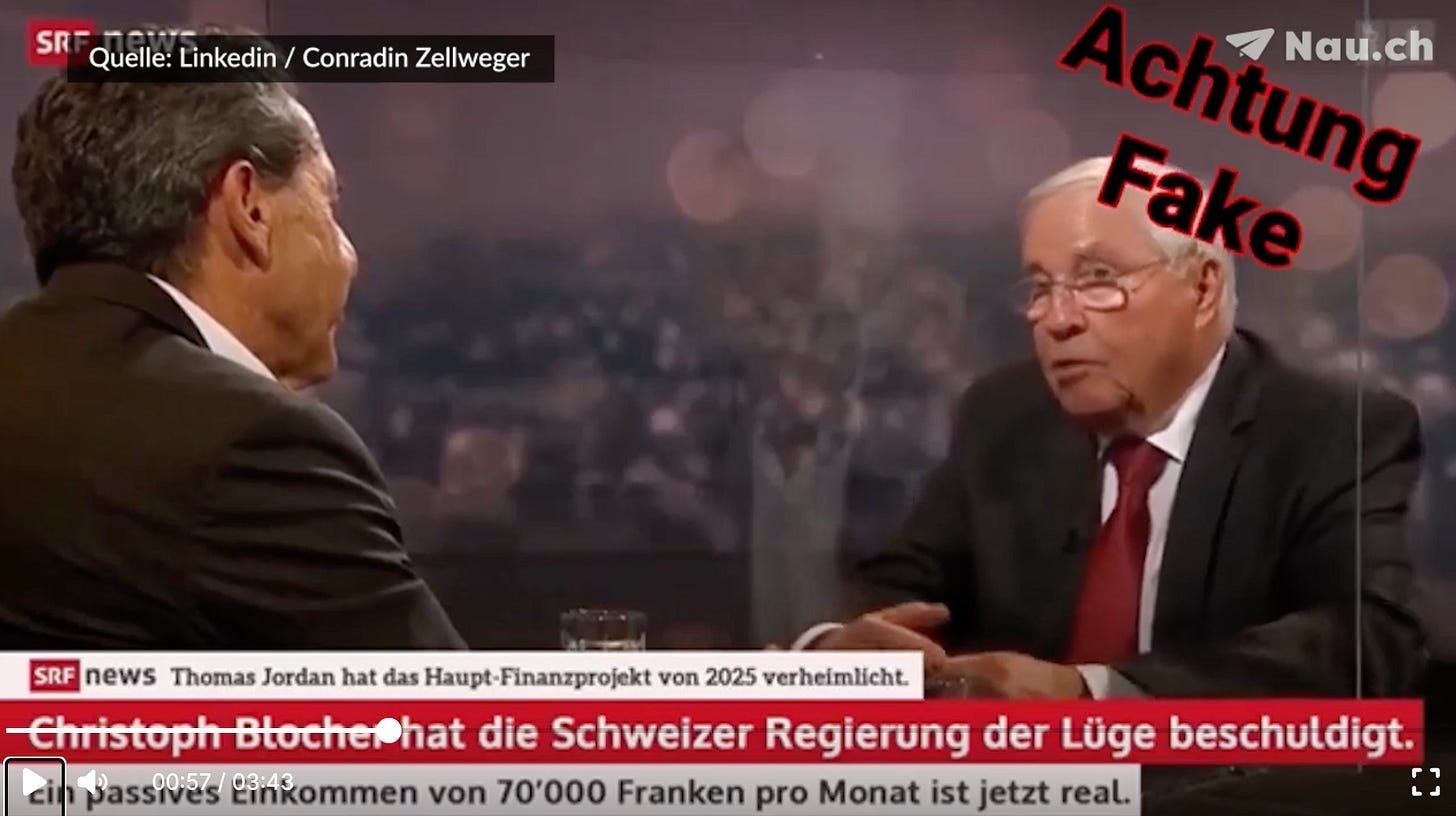

„Nur Dumme fallen auf Betrug rein.“ Viele Leute sind überaus selbstbewusst, wenn es um dieses Thema geht, und sehen sich ausgenommen von den vielen Fällen. Denn „ihnen würde das nie passieren“. Die schiere Menge des Betrugs zeigt jedoch, dass nicht nur „Dumme“ Betrugsopfer werden. Cybercrime ist mittlerweile die drittgrösste „Wirtschaft“ der Welt mit einem Volumen von 9.5 Billionen Dollar. Das ist mehr, als die meisten Länder erwirtschaften!

Künstliche Intelligenz verschärft diese Bedrohung noch. Deepfakes werden bereits für Finanzbetrügereien eingesetzt und KI-gestützte Social-Engineering-Taktiken nutzen menschliche Schwachstellen gezielt aus.

In diesem Artikel gehe ich auf fünf Deepfake-Technologien ein, die uns täuschen und in Betrugsszenarien eingesetzt werden könnten.

🔄️ Face-Swap

🎶 Audio-Deepfake

🪆 Puppet-Master

👄 Lip-Syncing

🧐 Gesichtssynthese

1. Face Swap

Beim Face Swap (Gesichtertausch) wird das Gesicht einer Person mithilfe von Algorithmen oder künstlicher Intelligenz auf den Körper einer anderen Person „montiert“. Face Swap kann live, beispielsweise mit Social-Media-Filtern, oder für einzelne Fotos und Videos, auch in Videocalls durchgeführt werden.

Ein Beispiel für ein Face-Swap-Tool ist DeepLiveCam:

Dabei handelt es sich um eine Software, die in Echtzeit das Gesicht anzeigt, das von einem Foto eingelesen wird.

Ein Betrugsbeispiel ist der „Deepfake-Fall“ aus Hongkong 2024: Ein Finanzmitarbeiter eines Unternehmens in Hongkong wurde zu einer Videokonferenz eingeladen, in der verschiedene „Kollegen” und der „CFO” per Deepfake auftraten.

Das täuschend echte Chat-Setting führte dazu, dass der Mitarbeiter 25 Millionen US-Dollar auf Anweisung der vermeintlichen Führungskraft überwies.

2. Audio-Deepfakes / Voice Cloning

Ein Audio-Deepfake ist eine künstlich erzeugte Tonaufnahme, bei der mithilfe von KI die Stimme einer Person täuschend echt nachgeahmt wird. Dazu werden in der Regel Sprachdaten der Zielperson gesammelt und ein KI-Modell darauf trainiert, diese Stimme naturgetreu nachzubilden. Es benötigt nur 20 Sekunden der Stimmaufnahme.

Die KI kann daraufhin beliebige neue Aussagen generieren, die wie von der echten Person gesprochen klingen. Entweder wird Text in künstliche Sprache („Text-to-Speech“) umgewandelt oder vorhandene Audiodaten werden genutzt, um die Stimme einer Person zu klonen.

Typische Anwendungen und Risiken:

Betrug, beispielsweise durch Anrufe mit gefälschter Chef- oder Familienstimme („Enkeltrick“)

Verbreitung von Falschinformationen, indem bekannten Personen Aussagen untergeschoben werden

Überwindung der Spracherkennungs-ID bei Call Centern

Identitätsdiebstahl

Echtes Video mit Voice-Cloning-Inhalt hinterlegen, damit die Person etwas ganz anderes sagt

Ein Betrugsbeispiel sind Anrufe mit geklonten Stimmen aus der Familie, die einen „Notfall“ haben und Hilfe benötigen:

Video: aus Fox News Bericht

Ein anderes Beispiel ist der sogenannte CEO-Fraud: Ein Ferrari-Manager erhielt einen Anruf von einem Betrüger, der genau wie der CEO klang.

Der Anrufer forderte eine Überweisung, doch dies ist ein positives Beispiel. Denn der Manager enttarnte den Betrug, indem er den Anrufer nach einer Buch-Empfehlung fragte, die der CEO ihm erst letzte Woche gegeben hatte. Der Betrüger konnte darauf natürlich keine passende Antwort liefern.

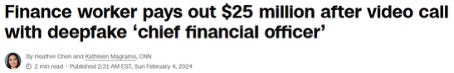

Echte Videos können zudem mit Voice Cloning so verfälscht werden, dass sie eine andere Aussage haben. So erging es dem Alt-Bundesrat Blocher, als er plötzlich Investitionsempfehlungen abgab, anstatt ein gewühnliches Interview bei Schawinski zu führen.

Ein anderes Beispiel ist Roger Federer, der plötzlich vom Investieren spricht.

3. Puppet Master

Bei der Puppet-Master-Technologie, einer speziellen Form von Deepfake, werden die Mimik, Kopfbewegungen und Gesten einer „Steuerperson“ (dem Puppet-Master) auf das Gesicht und den Kopf einer Zielperson übertragen.

Die KI zeichnet die Gesichtsbewegungen und Gestik einer realen Person auf

Diese Bewegungen werden in Echtzeit oder für ein Video auf eine andere Person übertragen

So sieht es aus, als würde die Zielperson die Bewegungen und Ausdrucksweisen der Steuerperson ausführen, obwohl dies nicht der Fall ist

Dabei kann auch die Stimme der Steuerperson übertragen oder mit Audio-Deepfake-Technologie kombiniert werden

Es wirkt, als würde der Puppet-Master die Zielperson wie eine Marionette kontrollieren. Der Unterschied zum Face Swap besteht darin, dass nicht das komplette Gesicht ersetzt wird, sondern nur die Mimik.

So können beispielsweise ganz fiktive Personen aus KI erstellt werden, die mit dem Puppet Master zum Leben erweckt werden.

Das eröffnet eine ganz neue Dimension für Romance Scams. So kann beispielsweise ein Mann eine hübsche, KI-generierte Frau sein und dies auch im Videocall beweisen.

Oder dieses Beispiel war vor 4 Jahren:

Mithilfe dieser Technologie kann auch immer direkter Augenkontakt in Video-Calls vorgetäuscht werden.

Ich habe hier einmal ein Beispiel mit mir erstellt:

Einfach ein Video mit einem GenAI-Video-Tool erstellen (das war im Januar 2025, inzwischen geht es noch einiges besser).

Einsprechen, was er sagen sollte.

Et voilà!

Avatar der einfach etwas einspricht generieren (hier als Beispiel via Kling AI):

Ich spreche als Vorbild ein, was er sagen soll:

Der Avatar wird zu meiner Marionette:

4. Lip-Syncing

Beim Lip-Syncing werden die Lippenbewegungen automatisch mit einer Tonspur oder gesprochenem Text synchronisiert. Dabei sorgt die KI dafür, dass die Lippenbewegungen einer Person in einem Video genau zu den gesprochenen Worten passen.

Mit Lipsync lassen sich also Videos erzeugen, die realistisch wirken, obwohl die Person tatsächlich etwas anderes sagt.

Beispiel aus der Betrugswelt: In einem Deepfake-Video werden die Lippenbewegungen einer Person so manipuliert, dass sie genau zu einem neu aufgenommenen oder generierten Audiotext passen.

Dies wurde höchstwahrscheinlich in diesen Scam-Videos gemacht, in denen Deepfakes von SRF-Moderatoren erstellt wurden, damit sie Investitionen ankündigen, statt die normale Tagesschau zu moderieren.

Durch das Lipsyncing sehen Deepfakes noch echter aus.

Hier hatte ich auch einmal ein Beispiel erstellt:

Es zeigt eine Moderatorin, die ursprünglich nur ein Midjourney-Bild war und mithilfe von Lipsyncing an den gesprochenen Text angepasst wurde. Die Moderatorin bestand zuerst nur aus Bildern, wie den folgenden:

5. Gesichtssynthese

Bei der Gesichtssynthese werden mithilfe von KI und neuronalen Netzen realistisch aussehende Gesichter oder Gesichtsanimationen erzeugt. Dabei kann es sich um komplett neue, künstliche Gesichter handeln, die es in der Realität nicht gibt, oder um Animationen realer Gesichter mit neuen Gesichtsausdrücken, Blickrichtungen und Bewegungen.

Die KI lernt aus vielen Bildern und Videos von Gesichtern, wie typische Merkmale, Lichtverhältnisse und Texturen aussehen.

Anschliessend kann sie neue Gesichter erzeugen oder bestehende Gesichter so animieren, dass sie natürlich wirken (z. B. für Filme, Spiele oder Deepfakes).

Die Gesichtssynthese umfasst neben statischen Bildern auch dynamische Bewegungen, Mimik und Ausdrucksveränderungen, die nahtlos in Videos eingefügt werden können.

Unglaublich echt aussehende Bilder, die alle nicht existieren, findet ihr hier: https://www.thispersondoesnotexist.com/

Diese Art der Deepfake-Technologie kann auch für Identitätsbetrug ausgenutzt werden, um synthetische, also gefälschte, Identitäten zu erstellen. Ein Beispiel dafür ist der Fall eines koreanischen Hackers, der sich bei KnowBe4 einen Job beschaffte: Seine gesamte Identität war erfunden. Ihm wurde ein Firmenlaptop nach Hause geschickt, was bei Entwicklern, die von zu Hause aus arbeiten, üblich ist. Doch dann gingen im Security Operations Center interne Alarme los. Kaum hatte der neue Mitarbeiter den Computer in der Hand, begann er, Schadsoftware zu installieren. Diese Person war nicht, wer sie vorgab zu sein. Sie hatte das Profil eines echten Menschen gestohlen. Foto, Lebenslauf und Online-Spuren waren entweder erfunden oder stammten von anderen Personen.

Angreifer erstellen sogenannte synthetische Identitäten, da sie damit ein geringeres Risiko eingehen, entdeckt zu werden, als beim Diebstahl echter Identitäten.

Mit diesen täuschen sie beispielsweise Unternehmen bei Bewerbungen, E-Mails oder Anrufen. Da keine echte Person dahintersteht, bleiben sie länger unentdeckt. Niemand beschwert sich über eine falsche Rechnung oder eine unaufgefordert zugeschickte Kreditkarte.

Headshots können mithilfe einer Vorlage synthetisch verfälscht werden, wie in diesem Beispiel von einem Foto aus Canva zu sehen ist:

Gefälschte Portfolios und Lebensläufe können durch KI-generierte oder kopierte Arbeitsproben, Zeugnisse und Projektportfolios ergänzt werden, um das Bild einer kompetenten Person zu vervollständigen.

Es lohnt sich die Technologien zu kennen

Deepfake-Technologien verändern die Bedrohungslandschaft derzeit sehr schnell. Verfügbare Werkzeuge sind Face-Swap, Audio-Deepfakes, Puppet-Master-Technologie, Lip-Syncing und Gesichtssynthese. Während sich die Angriffsmethoden täglich weiterentwickeln, bleibt unser Gehirn und die Wahrnehmung gleich. Bei ungewöhnlichen Anfragen per Videoanruf, Telefon oder E-Mail sollten wir also lieber einmal zu viel zusätzliche Bestätigungen einholen. Wenn wir wissen, welche Methoden angewendet werden und wie sie aussehen, können wir uns auch davor schützen!

Bis bald

Jill

Quellen:

Deepfake: KI-Aufnahmen erkennen: Prävention & Risiken. (o. J.). Abgerufen 23. August 2025, von https://lawpilots.com/de/blog/it-sicherheit/deepfake-phishing-neue-gefahren-fuer-unternehmen-und-organisationen/

Face Swap. (2025). In Wikipedia. https://de.wikipedia.org/w/index.php?title=Face_Swap&oldid=256848198

FOX 4 Dallas-Fort Worth (Regisseur). (2023, September 20). Expert demonstrates how AI voice scams work [Video recording].

Hier spricht nicht Roger Federer über das schnelle Geld. (2023, Dezember 21). Blick. https://www.blick.ch/wirtschaft/aufgepasst-vor-ki-betruegern-auf-youtube-hier-spricht-nicht-roger-federer-ueber-das-schnelle-geld-id19266766.html

Ho, G., Mirian, A., Luo, E., Tong, K., Lee, E., Liu, L., Longhurst, C. A., Dameff, C., Savage, S., & Voelker, G. M. (o. J.). Understanding the Efficacy of Phishing Training in Practice.

Magramo, H. C., Kathleen. (2024, Februar 4). Finance worker pays out $25 million after video call with deepfake ‘chief financial officer’. CNN. https://www.cnn.com/2024/02/04/asia/deepfake-cfo-scam-hong-kong-intl-hnk

Sprach-Deepfakes: Technologie, Perspektiven, Betrug. (2023, Juli 19). https://www.kaspersky.de/blog/audio-deepfake-technology/30344/

Voice Cloning with Deep Learning Models – Compass Security Blog. (o. J.). Abgerufen 23. August 2025, von https://blog.compass-security.com/2024/10/voice-cloning-with-deep-learning-models/

Wick, J. (2025, Juli 20). Newsletter: #27 Desinformation (1). https://www.newsletter.jillwick.com/p/newsletter-27-desinformation-1