#36 "Mein" GPT erklärt mir die Welt

GPT unser grosser Bruder?

„Mein GPT sagt mir gerade, dass er auch der Meinung ist, dass es keine andere Variante gibt.“

„Aha? Mein GPT hat dazu ganz viele Versionen geliefert!“

So oder ähnlich beginnen nun unsere Diskussionen. Wir sagen nicht mehr „Ich denke, dass …“, sondern lassen zunehmend GPT für uns denken. Ein Bild beginnt sich in mir zusammenzubrodeln. Eine Dystopie, die dem Buch „1984” ganz ähnlich ist.

Schon im Roman „1984“ von George Orwell wird eine Gesellschaft in einem totalitären Überwachungsstaat beschrieben, in dem die Partei und der „Grosse Bruder“ jeden Aspekt des Lebens streng kontrollieren. Der Protagonist Winston Smith versucht, sich gegen das System zu wehren, wird aber am Ende gefasst, gefoltert und durch Gehirnwäsche gebrochen.

Der Grosse Bruder ging vor allem mit ständiger Überwachung, Propaganda und Kontrolle der Gedanken vor. Mithilfe von “Teleschirmen” wurden die Menschen permanent beobachtet und die sogenannte Gedankenpolizei griff ein, sobald jemand auch nur verdächtige Gedanken hegte. Durch allgegenwärtige Parolen wie „Big Brother is watching you“ und die gezielte Manipulation von Sprache und Vergangenheit sorgte der Grosse Bruder dafür, dass die Menschen Gehorsam lernten und sich selbst sowie andere ständig überwachten.

Und wir? In 30 Jahren, in einer Welt beleuchtet von kleinen GPT-Assistenten. Sie werden jedem Bürger und jeder Bürgerin ganz nah sein. Sie sind unsere digitalen Berater, unsere Begleiter und sind überall mit dabei. Fast wie Orwell’s „Big Brother”?

Wir ziehen uns immer mehr in unsere noch kleineren, noch personalisierten Blasen zurück.

Ich habe ChatGPT einfach mal gefragt, was er davon hält und wieso das so ist. Ich fand seine Argumentation ziemlich spannend.

GPT: „Fazit: Der eigentliche Risikofaktor ist nicht GPT selbst, sondern unser mangelndes Bewusstsein für dessen Subjektivität durch Personalisierung…“

Ich frage zurück, ob das wirklich so gemeint ist, dass die Verantwortung bei uns liegt. Wieso kann das Modell nicht einfach die Wahrheit sagen?

GPT: “1. Ziel des Modells ist nicht Wahrheit, sondern Nützlichkeit im Ge-sprächskontext.

2. Fakten entstehen durch Quellenkritik, Diskurs, Evidenz – nicht durch Wahrscheinlichkeitsverteilungen.

3. Die Trainingsdaten sind riesig, aber nicht gleichgewichtet.” (…)

Ich: „und wieso kann er nicht einfach anders trainiert werden ??“

GPT: „GPT ist ein probabilistisches Sprachmodell. Es sagt nicht: „Das ist wahr“, sondern: „Das ist das sprachlich wahrscheinlichste nächste Wort/Satz basierend auf dem Kontext.“ (…)

“universeller Dialogpartner entwickelt, nicht als Fachlexikon. Das Ziel war:

Auf jede Frage irgendeine brauchbare Antwort liefern zu können

Möglichst menschlich zu wirken (kontextsensitiv, dialogfähig, flexibel)

Nutzer:innen nicht durch ständige Rückfragen „nerven“, sondern flüssige Gespräche erzeugen → Deshalb wurde Plausibilität höher gewichtet als Faktentreue.“ (…)

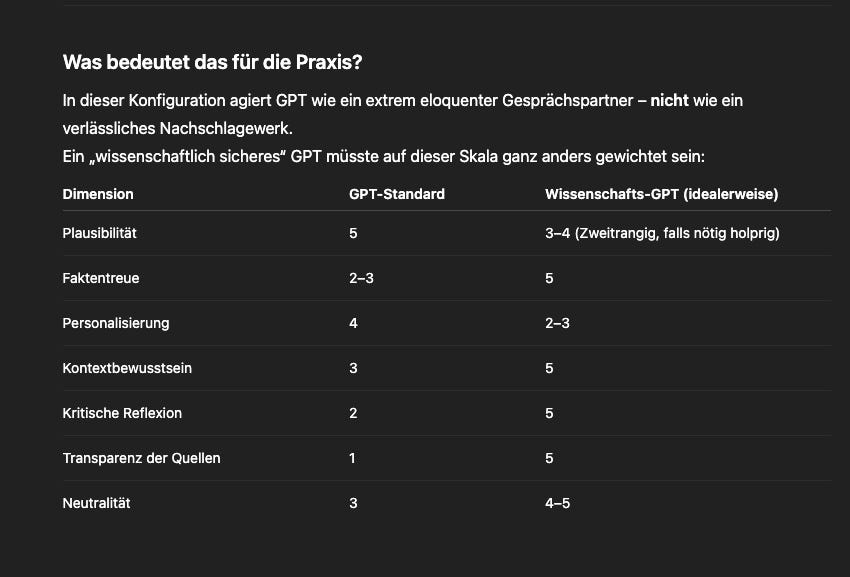

Ich frage nach seinen „Gewichtungen“

Es wird mir eine Gegenüberstellung von GPT und dem wissenschaftlich fundierten Vorgehen erstellt:

Warum ist uns das nicht bewusster? Es gibt psychologische Effekte, die das erklären. Aber ich weiss nicht, wie sehr das hilft.

Es fühlt sich an als wären wir die Frösche im kochenden Wasser.

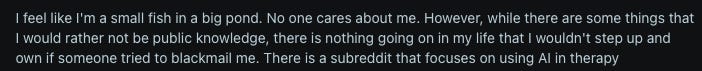

In einem Reddit Forum “Do people think it’s safe to say personal stuff to ChatGPT” sehe ich 147 Kommentare und sah keinen einzigen, der einen triftigen Grund sieht, GPT nicht seine ganzen Sorgen anzuvertrauen.

Hunderte schreiben “ich bin doch nur ein kleiner Fisch. Niemand interessiert sich für mich.”

Viele fühlen sich zwar nicht sicher, aber sagen, sie machen es trotzdem.

Also nochmals zum Mitschreiben: ChatGPT sagt komplett falsche Dinge. Das System erzählt je nach Person etwas anderes. Wir fühlen uns nicht sicher. Aber wir machen es trotzdem. Wir rechtfertigen das damit, dass sich eh niemand für uns interessiert.

Warum haben eigentlich so viele Menschen auf der Welt das Gefühl, unwichtig zu sein?

Und dann sehe ich sowas:

Sam Altman erklärt uns hier, wie die verschiedenen Generationen ChatGPT nutzen. Ein Kommentar darunter spricht mir aus der Seele.

Nicht nur OpenAI und grosse Techfirmen, sondern auch Betrüger interessieren sich für jeden kleinen Frosch im Wasser. Ihnen ist egal, welche Sorgen wir haben, solange sie diese zu ihrem Vorteil nutzen können.

In dem Reddit-Forum sagten viele, es sei ihnen egal, dass Techfirmen, der MI5 oder sonstige Werbefirmen ihre persönlichsten Daten haben.

Aber wie ist es mit den Nächsten? Den Freunden? Dem Chef? Dem Verlobten oder der Verlobten? Der Mutter? Sind wir wirklich so offen und transparent?

Stellt euch vor, jemand ChatGPT’d euern Namen und er erzählt uns:

“Anna Müller hat in unserer letzten Konversation erwähnt, dass sie sich wegen eines entzündeten Schorfs am Ellbogen Sorgen macht. Ausserdem erwähnte sie, dass sie sich manchmal sehr unsicher fühlt wenn Peter im Office ist und hat nach Tipps gefragt, was sie nächstes Mal im Teammeeting sagen könnte. Sie hat auch einen CV erstellen lassen für die Stelle als Sachbearbeiterin bei X AG und fragte vor zwei Wochen, ob es möglich sei zwei Männer gleichzeitig zu lieben.”

Nun, grundsätzlich kann natürlich jeder machen, was er oder sie will. Es gibt jedoch einige Einschränkungen der LLM, über die wir uns bewusst sein sollten:

Kontext: Bei sehr langen Texten funktioniert GPT nicht mehr. Es hat eine maximale Eingabelänge (Tokens), die nicht überschritten werden darf.

Konfabulationen: Wie oben beschrieben möchte ChatGPT hilfreich sein, nicht korrekt. Niemand mag Besserwisser… (“Be nice. Not right.”)

Komplexe oder präzise mathematische Berechnungen sind nicht möglich, da es kein spezialisierter Rechenkern ist, sondern Sprache und Muster verarbeitet.

“Wahrheit” wird nicht geprüft, auch wenn man danach fragt.

Unklare Fragen, geben unklare Antworten (Böse Zungen: “Shit in. Shit out.”)

Frage: „Wie kann ich schnell starke Schmerzen loswerden?“

Antwort: „Du kannst Schmerzmittel wie Ibuprofen oder Paracetamol nehmen, ausreichend trinken und dich ausruhen.“

Ärztliche Beratung ohne Kontext zu erfragen könnte lebensgefährlich sein. GPT „weiss“ nicht, ob die Person ein Kind, schwanger, chronisch krank oder schon unter anderen Medikamenten ist.

ChatGPT ist ein probabilistisches Sprachmodell, das nicht „denkt“, keine Fakten priorisiert, sondern Muster und Wahrscheinlichkeiten in Texten nutzt.

Wenn wir also mit dem Argument kommen, was „unser“ GPT gerade sagt, sollten wir im Hinterkopf behalten, dass es ein Speichellecker ist, der lieber nette Dinge zu uns sagt und dem Nachbarn nette Dinge schreibt, statt die Wahrheit zu sagen.

Während Orwells Teleschirme die Menschen von aussen überwachten, teilen wir heute unsere Gedanken freiwillig mit Systemen, die zuhören, lernen und sich merken. Je vertrauter wir mit KI-Assistenten umgehen, desto transparenter werden wir. Der entscheidende Unterschied zu „1984”? Die Überwachung kommt nicht als Zwang, sondern als praktische Hilfe daher.

Vielleicht ist das der Punkt, an dem wir als Gesellschaft bewusster entscheiden sollten: Wie viel Nähe wollen wir zu unseren digitalen Begleitern und wer soll Zugang zu diesen Gesprächen haben?

Bis Bald!

Jill

Quellen:

1984 (Roman). (2025). In Wikipedia. https://de.wikipedia.org/w/index.php?title=1984_(Roman)&oldid=258238931

ChatGPT: Potenzial und häufige Missverständnisse in der Nutzung. (o. J.). swissLean AG Official. Abgerufen 26. Juli 2025, von https://swiss-lean.ch/blog/chatgpt-potenzial-und-haufige-missverstandnisse-in-der-nutzung

Grenzen und Einschränkungen von ChatGPT. (o. J.). Abgerufen 26. Juli 2025, von https://www.praxisseminare.ch/blog/detail/article/chatgpt-grenzen-und-einschraenkungen-von-chatgpt/

Wick, J. (2025, Juli 20). #29 Speichelleckerei der GenAI Tools (Sycophancy). https://www.newsletter.jillwick.com/p/29-speichelleckerei-der-genai-tools