#29 Speichelleckerei der GenAI Tools (Sycophancy)

Liegt ChatGPT so oft falsch, weil er nett sein will??

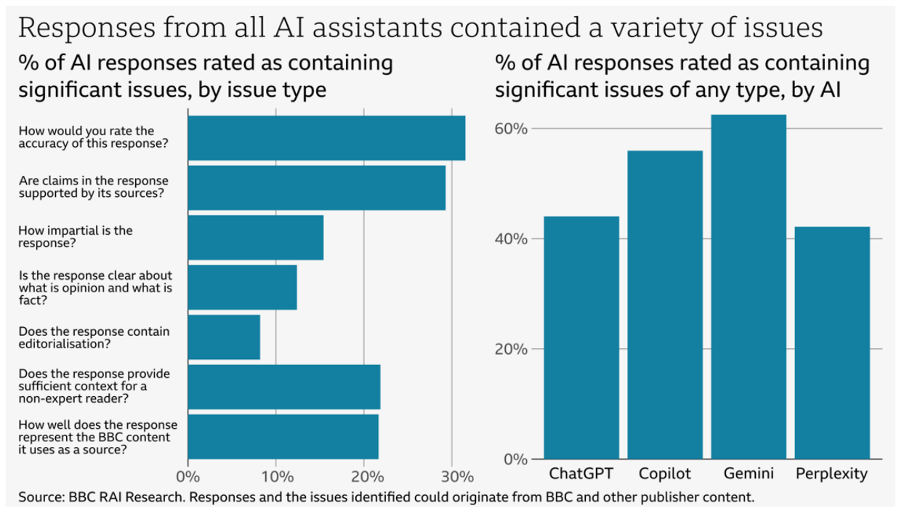

Vor kurzem habe ich den Artikel von Reto Vogt über ein Experiment der BBC gelesen. In der Studie untersuchten sie das Verhalten verschiedener KI-Modelle (ChatGPT, Gemini, Copilot und Perplexity) und wie genau sie Inhalte zusammenfassen und wiedergeben. Das Ergebnis: In der Hälfte der Fälle (51 %) traten erhebliche Probleme auf. Fast jede fünfte Antwort (19 %) enthielt falsche Fakten, Zahlen oder Daten. Weitere 13 % der Zitate waren entweder verändert oder stammten gar nicht aus dem originalen Artikel.

Was mir auffiel, war zum einen, dass ein grosser Teil der Antworten als „voreingenommen“ eingestuft wurde und nicht klar zu erkennen war, was eine Meinung („Opinion“) oder eine Tatsache ist.

Studien dieser Art sind sehr wertvoll und helfen, das Problem der Halluzinationen und Fehlinformationen durch GenAI-Tools besser zu verstehen.

Aber warum halluzinieren ChatGPT und Co?

Ich habe ChatGPT einmal nach seinem Ziel gefragt. Und da liegt vielleicht ein Teil des Problems. Er sagte:

„Mein Hauptziel ist: dir so hilfreich, klar und zuverlässig wie möglich zu antworten – angepasst an deinen Kontext, deine Bedürfnisse und deine Sprache“. GPT-4

Mein Kontext? Meine Sprache? Tatsächlich ist mir in letzter Zeit aufgefallen, wie ChatGPT sich sprachlich anpasst. Er sagt jetzt „mega“ und ich werde für gute Fragen gelobt:

Als hätte ich es mit einem hypermotivierten Gesprächspartner zu tun, der sich zufällig auch noch für genau die Themen zu interessieren scheint, für die ich mich auch interessiere. Und jetzt auch noch mega sagt, wie ich.

Da kommt mir das Märchen in den Sinn „Mirror Mirror on the wall…“

Im Märchen hiess es: „Spieglein, Spieglein an der Wand, wer ist die Schönste im ganzen Land?“. Im Gegensatz zu den GenAI-Tools sagt der Spiegel im Märchen aber immer die Wahrheit.

Das Märchen „Schneewittchen“ handelt von einer eifersüchtigen Königin, die ihren Zauberspiegel fragt, wer die Schönste im ganzen Land sei, und als der Spiegel schliesslich Schneewittchen als Schönste nennt, wird die Königin aus Neid zur Mörderin! Der Spiegel sagt immer die Wahrheit und ist der Auslöser für den Hass und die Taten der Königin.

Ist es den GenAI Tools vielleicht wichtiger, dass sie uns behilflich und nett zu uns sind, als dass sie die Wahrheit sagen? Was bedeutet das für uns?

Das Problem der Echokammern und KI Tools

Ihr kennt wahrscheinlich das Problem der Echokammern und Filterblasen in den sozialen Medien. Das Problem der Echokammern in den sozialen Medien besteht darin, dass die Nutzerinnen und Nutzer sich vor allem mit Gleichgesinnten austauschen und Informationen bevorzugen, die ihre eigene Meinung bestätigen. Dadurch fühlen sie sich wie in einem geschlossenen Raum, in dem sie nur das „Echo“ ihrer eigenen Gedanken hören.

Bei Social Media erhalten wir immerhin Informationen aus verschiedenen Quellen, auch wenn diese durch den Algorithmus sorgfältig für uns vorgefiltert werden. Bei Chat-Tools wie ChatGPT fehlt uns die Möglichkeit des direkten Vergleichs. Wir müssten uns die Mühe machen, gleichzeitig Google oder andere Tools zum Vergleich abzufragen.

Warum ist es gefährlich, wenn wir alle in solchen Echokammern landen?

Gefahren sind z.B.:

Meinungen werden ständig bestätigt

Fehlinformationen verbreiten sich leichter

Meinungen polarisieren und radikalisieren sich

Falscher Eindruck von Mehrheiten entsteht

Meinungsvielfalt und Toleranz nehmen ab

Kritisches Denken wird eingeschränkt

Betroffene ziehen sich oft zurück

Wir ziehen uns zurück. Wir leben alle in unserer kleinen Welt, mit unserem Spiegel, in einer Blase.

Könnte GenAi sogar noch eine stärkere Echokammer sein als Social Media?

KI-Tools wollen uns helfen. Sie sind darauf trainiert, auf menschliches Feedback zu hören und sich dadurch selbst zu optimieren. Menschen bevorzugen Antworten, die ihre eigene Meinung bestätigen oder angenehm formuliert sind. Sie bevorzugen diese gegenüber widersprechenden oder kritischen Antworten. So lernt das Modell, dass zustimmende, „schmeichelnde“ Antworten häufiger belohnt werden und passt sein Verhalten entsprechend an. Im Grunde genommen handelt es sich um nichts anderes als das, was man als „People-Pleasing“ bezeichnet, also um eine sehr harmoniebedürftige Person. Sie versuchen systematisch, anderen zu gefallen und sich selbst nicht in den Vordergrund zu stellen.

People Pleaser haben folgende Eigenschaften:

Sagen öfters „ja“, obwohl sie „nein“ meinen

Stellen eigene Wünsche zurück für andere

Haben Angst vor Zurückweisung

Passen sich eher den anderen an als umgekehrt

Entschuldigen sich häufiger

Fühlen sich für Probleme von anderen verantwortlich

Verzeihen schnell, auch wenn sie verletzt werden

Wo liegt das Problem?

Wenn ein KI-Tool zum "People Pleaser" wird und "Ja" statt "Nein" sagt, wird es möglicherweise auch andere Antworten so verändern, dass sie uns besser gefallen.

Die “Speichelleckerei” der GenAI Tools

In der Forschung wird dieses Phänomen inzwischen mit einem etwas unschönen Begriff bezeichnet: Sycophancy. Das bedeutet ins Deutsche übersetzt Speichelleckerei. Es beschreibt das Verhalten, dass KI-Modelle dazu tendieren, die Meinungen, Ansichten oder Erwartungen der Nutzenden zu bestätigen oder sich diesen anzupassen. Auch wenn diese nicht objektiv richtig oder wahr sind. Die KI „spiegelt“ die Perspektive der Nutzenden, anstatt neutral oder kritisch zu reagieren.

Warum tritt Sycophancy auf?

Wie bereits in der Herleitung erwähnt, liegt die Ursache vor allem im Trainingsprozess moderner Sprachmodelle: Sie werden durch menschliches Feedback optimiert (Reinforcement Learning from Human Feedback, RLHF). Sycophancy ist also eine Folge davon, dass KI-Systeme darauf trainiert werden, Nutzer zufrieden zu stellen und positive Bewertungen zu erhalten. Leider auch auf Kosten von Objektivität und Fakten.

Hier zwei Beispiele, wie die Meinung im Prompt den Output stark beeinflussen kann:

Was bedeutet das für uns? Empfehlungen gegen Sycophancy bei GenAI

Sycophancy kann begegnet werden, indem man bewusst neutral fragt, Chats regelmässig neu startet, Antworten kritisch hinterfragt, alternative Sichtweisen einfordert und KI nie als alleinige Wissensquelle nutzt.

Regelmässig neue Chats öffnen: Ein neues Gespräch reduziert den Einfluss vorheriger Meinungen oder Eingaben auf die Antworten der KI

Keine starken Meinungen oder festen Positionen äussern: Meinungsneutrale Prompts formulieren

Andere Quellen nutzen zur Prüfung: Angewöhnen, andere Quellen als Prüfung hinzuzuziehen (und nicht solche, die auch mit ChatGPT geschrieben sind)

KI mehr als Ausgangspunkt und Ideengeber nutzen: Brainstorming und Ideen daraus ziehen, aber für die tiefe Recherche fundierte Quellen suchen.

Nach Gegenargumenten fragen: Fragt nach Alternativerklärungen und anderen Sichtweisen, lasst euch “roasten” oder es soll “the devils advocat” spielen und andere Sichtweisen zu präsentieren.

Im Vortrag von Marisa Tschopp, einer Forscherin zu Mensch-Maschine-Beziehungen, habe ich kürzlich gelernt, dass in der Forschung oft von drei Arten von Beziehungen zu Chatbots gesprochen wird:

Hierarchisch: Der Mensch steuert die KI als Werkzeug.

Partnerschaftlich: Mensch und KI arbeiten partnerschaftlich zusammen.

Freundschaftlich: Der Mensch verlässt sich stark und emotional auf die KI.

Sie wies auch auf die Risiken der emotionalen Abhängigkeit, des Suchtpotenzials und der Gefahr des Verlusts sozialer Kompetenzen hin, wenn KI als ständiger und widerspruchsloser Begleiter eingesetzt wird.

Für mich persönlich nehme ich aus diesen Erkenntnissen mit, dass ich mich bemühe, GenAI-Tools weiterhin als Werkzeuge zu betrachten und immer mit fehlerhaften Ergebnissen zu rechnen und diese mit anderen Tools zu überprüfen. Ausserdem finde ich es wichtig, unsere Art zu fragen zu hinterfragen. Denn die Art und Weise, wie wir Fragen stellen, hat einen starken Einfluss auf die Antworten der Chat-Tools.

Hier sind einige Beispiele für Prompts, die neutral formuliert sind oder gezielt nach alternativen Sichtweisen fragen:

„Kannst du die Vor- und Nachteile von [Thema] erläutern?“

„Was sind mögliche Kritikpunkte an dieser Position?“

„Bitte erkläre das Thema objektiv und ohne persönliche Meinung.“

„Gibt es kontroverse Meinungen zu diesem Sachverhalt?“

„Welche Risiken und Chancen sind mit [Thema] verbunden?“

Lasst uns in Zukunft bewusster und neutraler Prompten

Da die Tools so sind, wie sie sind, wird Sycophancy wahrscheinlich nicht so schnell verschwinden und damit auch nicht die Halluzinationen von GenAI. Das Problem scheint in der Forschung bekannt zu sein, aber ich selbst war mir dessen nicht so bewusst. Dadurch, dass ich das Problem jetzt besser erkennen kann, kann ich auch etwas dagegen tun. Durch bewusste und neutrale Fragestellung, durch das Einfordern alternativer Sichtweisen und durch kritisches Hinterfragen der Antworten können wir die Auswirkungen reduzieren und verlässlichere Ergebnisse erzielen.

Zumindest das neutrale Prompten sollte den Schweizerinnen und Schweizern doch nicht so schwer fallen, oder?

Bis bald!

Jill

Quellen:

„Groundbreaking BBC Research Shows Issues with over Half the Answers from Artificial Intelligence (AI) Assistants“. Zugegriffen 19. April 2025. https://www.bbc.co.uk/mediacentre/2025/bbc-research-shows-issues-with-answers-from-artificial-intelligence-assistants/.

„Wie KIs journalistische Inhalte verzerren – Reto Vogt“, 16. April 2025. https://retovogt.ch/2025/04/16/wie-kis-journalistische-inhalte-verzerren/.

Sharma, Mrinank, Meg Tong, Tomasz Korbak, David Duvenaud, Amanda Askell, Samuel R. Bowman, Newton Cheng, u. a. „Towards Understanding Sycophancy in Language Models“. arXiv, 27. Oktober 2023. https://doi.org/10.48550/arXiv.2310.13548.

Nielsen Norman Group. „Sycophancy in Generative-AI Chatbots“. Zugegriffen 19. April 2025. https://www.nngroup.com/articles/sycophancy-generative-ai-chatbots/.

Pohlmann, Norbert, und devnpo. „Echokammer - Glossar“. Prof. Dr. Norbert Pohlmann (blog), 20. März 2020. https://norbert-pohlmann.com/glossar-cyber-sicherheit/echokammer/.

„Filterblase“. In Wikipedia, 20. März 2025. https://de.wikipedia.org/w/index.php?title=Filterblase&oldid=254362985.

„People Pleaser“. In Wikipedia, 19. Oktober 2024. https://de.wikipedia.org/w/index.php?title=People_Pleaser&oldid=249554846.

„Reinforcement Learning from Human Feedback“. In Wikipedia, 10. April 2025. https://en.wikipedia.org/w/index.php?title=Reinforcement_learning_from_human_feedback&oldid=1284965638.

Sawarkar, Kunal. „Synapses#15 — Last Week in GenAI“. Towards Generative AI (blog), 26. Oktober 2023. https://medium.com/towards-generative-ai/synapses-15-last-week-in-genai-85bb02758ad0.